Opciones de operación en Jitterbit Studio

Introducción

Configura las opciones de operación para controlar los tiempos de espera, el registro y el procesamiento de datos. La mayoría de las operaciones funcionan bien con la configuración predeterminada, pero puedes personalizarlas para necesidades específicas.

Acceder a las opciones de operación

Puedes acceder a la opción de Configuración para operaciones desde estas ubicaciones:

- La pestaña Flujos de trabajo del panel del proyecto (ver Menú de acciones del componente en Pestaña Flujos de trabajo del panel del proyecto).

- La pestaña Componentes del panel del proyecto (ver Menú de acciones del componente en Pestaña Componentes del panel del proyecto).

- El lienzo de diseño (ver Menú de acciones del componente en Lienzo de diseño).

- El lienzo de diseño haciendo doble clic en la operación (esto abre Configuración directamente).

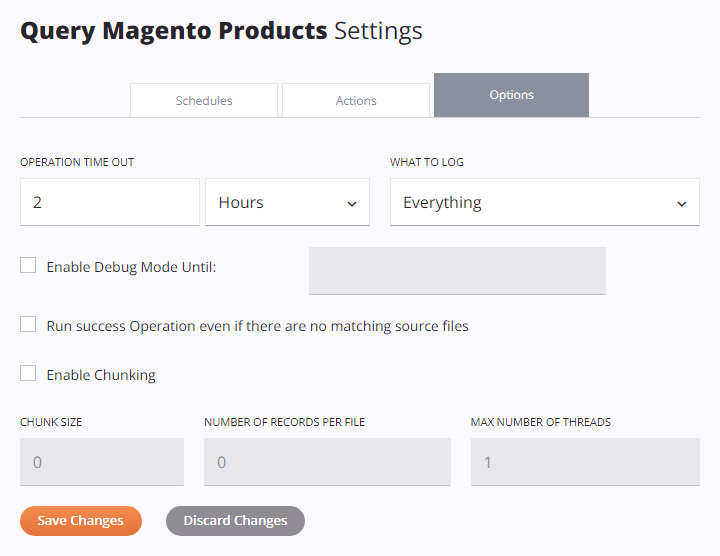

Después de que se abra la pantalla de configuración de la operación, selecciona la pestaña Opciones:

Configurar opciones de operación

Las siguientes secciones describen cada opción de operación:

- Tiempo de espera de la operación

- Qué registrar

- Habilitar modo de registro de depuración hasta

- Ejecutar operación de éxito incluso si no hay archivos fuente coincidentes

- Habilitar fragmentación

- Opciones de operación masiva de Salesforce

Tiempo de espera de la operación

Establece cuánto tiempo se ejecuta la operación antes de que se cancele. El valor predeterminado es de 2 horas, lo cual funciona para la mayoría de las operaciones.

Puede que desee ajustar esta configuración por las siguientes razones:

-

Aumentar el tiempo de espera para conjuntos de datos grandes que tardan más en procesarse. Las operaciones programadas que procesan grandes volúmenes de datos pueden necesitar tiempos de espera más largos. Si sus conjuntos de datos superan los límites de tiempo de espera, consulte Habilitar Fragmentación para opciones que dividen grandes conjuntos de datos en lotes más pequeños y controlan el número de registros escritos por archivo de salida.

-

Disminuir el tiempo de espera para operaciones sensibles al tiempo que deben completarse rápidamente.

Ingrese un número y seleccione Segundos, Minutos o Horas en el menú desplegable.

Nota

Las operaciones activadas por API Manager APIs ignoran esta configuración en agentes en la nube. Para agentes privados, habilite EnableAPITimeout en el archivo de configuración del agente privado para que la configuración de Tiempo de Espera de Operación se aplique a las operaciones activadas por APIs.

Qué registrar

Elija qué información aparece en los registros de operaciones:

- Todo: Registra toda la actividad de la operación (recomendado).

- Solo Errores: Registra solo operaciones con un estado de tipo error (como Error, Fallo de SOAP o Éxito con Error de Hijo). Use esta configuración si tiene problemas de rendimiento y no necesita registros detallados. Las operaciones hijas exitosas no se registran. Las operaciones padre (de nivel raíz) siempre se registran, ya que requieren registro para funcionar correctamente.

Habilitar Modo de Depuración Hasta

Active el registro detallado para la solución de problemas. Seleccione una fecha hasta dos semanas a partir de hoy. El modo de depuración se desactiva automáticamente en esta fecha.

Advertencia

En grupos de agentes en la nube, la duración de esta configuración es poco confiable. Los registros pueden dejar de generarse antes del final del período de tiempo seleccionado.

Cuando habilite el modo de depuración para operaciones con operaciones hijas, puede aplicar la misma configuración a todas las operaciones hijas utilizando la casilla de verificación También Aplicar a Operaciones Hijas.

El registro de depuración genera diferentes tipos de registros según su tipo de agente:

| Tipo de registro | Descripción del registro | Tipo de agente |

|---|---|---|

| Archivos de registro de depuración | Archivos de registro de depuración para una solución de problemas detallada. Puedes acceder a estos archivos directamente en el agente o descargarlos a través de la Consola de Administración. El registro de depuración también se puede habilitar para todo el proyecto desde el propio agente privado (ver Registro de depuración de operaciones). Los archivos de registro de depuración son accesibles directamente en agentes privados y se pueden descargar a través de las páginas de la Consola de Administración Agentes y Tiempo de ejecución. Advertencia El modo de depuración crea archivos de registro grandes. Úsalo solo durante las pruebas, no en producción. |

Solo agentes privados |

| Entrada y salida del componente | Datos de solicitud y respuesta (conservados durante 30 días). Accesibles a través de la página de la Consola de Administración Tiempo de ejecución. Cuidado Los datos de entrada y salida del componente siempre se registran en la nube de Harmony, incluso si el registro en la nube está deshabilitado. Para detener esto en agentes privados, establece Los registros de depuración contienen todos los datos de solicitud y respuesta, incluida información sensible como contraseñas e información personal identificable (PII). Estos datos aparecen en texto claro en los registros de la nube de Harmony durante 30 días. |

Agentes en la nube y privados |

| Registros de operaciones de API | Registros de operaciones de API exitosas (configurados para APIs personalizadas o APIs OData). Por defecto, solo se registran las operaciones de API con errores en los registros de operaciones. |

Agentes en la nube y privados |

Ejecutar operación de éxito incluso si no hay archivos fuente coincidentes

Esta opción obliga a que una operación tenga éxito incluso cuando su desencadenador falla. Esto permite que otras operaciones desencadenadas para ejecutarse En Éxito de esta operación se ejecuten independientemente del resultado de la operación inicial. Se aplica solo cuando la operación inicial contiene una actividad fuente para uno de estos conectores:

- API

- Compartición de Archivos

- FTP

- HTTP

- Almacenamiento Local

- SOAP

- Almacenamiento Temporal

- Actividad de Variable

Por defecto, cualquier operación En Éxito se ejecuta solo si tiene un archivo fuente coincidente para procesar. Esta opción puede ser útil para configurar partes posteriores de un proyecto sin requerir el éxito de una operación dependiente.

Nota

La configuración AlwaysRunSuccessOperation en el archivo de configuración del agente privado anula esta opción.

Habilitar Fragmentación

La fragmentación divide grandes conjuntos de datos en fragmentos más pequeños (lotes). Esto hace que el procesamiento sea más rápido y ayuda a cumplir con los límites de registros de la API. Para habilitar la fragmentación, su operación debe contener una transformación o una actividad de uno de estos conectores:

Utiliza el procesamiento por lotes en estas situaciones:

- Procesas grandes conjuntos de datos con miles de registros.

- Utilizas servicios web con límites de registros. Por ejemplo, Salesforce permite solo 200 registros por llamada.

- Quieres usar múltiples núcleos de CPU para procesamiento en paralelo.

Consejo

Para obtener orientación sobre cuándo usar procesamiento por lotes frente a procesamiento impulsado por eventos en proyectos de integración, consulta Procesamiento por lotes y procesamiento impulsado por eventos.

Cuando una actividad de Salesforce, Salesforce Service Cloud o ServiceMax está en la operación, el procesamiento por lotes se habilita automáticamente.

Cuando esta configuración está habilitada, configura estos campos:

-

Tamaño del Lote: El número de registros en cada lote. El valor predeterminado es

1para la mayoría de las operaciones y200para las operaciones de Salesforce.Nota

Cuando uses una actividad de (Salesforce, Salesforce Service Cloud o ServiceMax) en modo masivo, cambia este valor predeterminado a un número mucho mayor, como

10,000. -

Número de Registros por Archivo: El número de registros que se escribirán en cada archivo de destino (lote). El valor predeterminado es

0, lo que significa sin límite. -

Número Máximo de Hilos: El número de hilos de procesamiento que se ejecutan al mismo tiempo. El valor predeterminado es

1para la mayoría de las operaciones y2para las operaciones de Salesforce.

Advertencia

El procesamiento por lotes afecta cómo funcionan las variables globales y de proyecto. Solo se preservan los cambios del primer hilo. Consulta información detallada sobre el procesamiento por lotes a continuación.

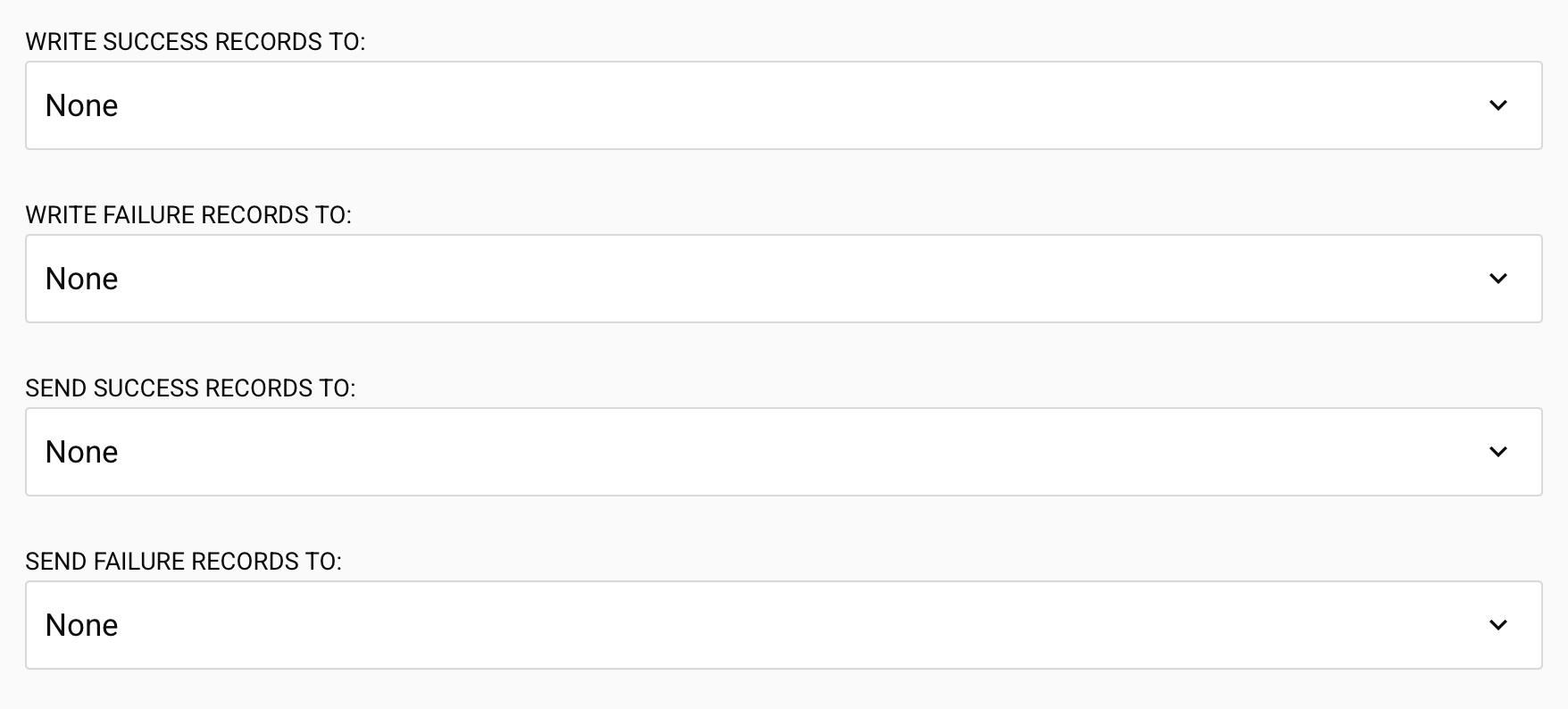

Opciones de operación masiva de Salesforce

Las siguientes opciones aparecen solo para operaciones masivas de Salesforce, Salesforce Service Cloud y ServiceMax (excepto las operaciones de Consulta Masiva):

-

Escribir registros de éxito en: Elija dónde enviar los registros exitosos después de que se complete la operación masiva. Seleccione entre actividades basadas en archivos configuradas: HTTP, API, FTP, Compartición de Archivos, Almacenamiento Local, Almacenamiento Temporal, o Variable. Predeterminado: Ninguno.

-

Escribir registros de fallo en: Elija dónde enviar los registros fallidos después de que se complete la operación masiva. HTTP, API, FTP, Compartición de Archivos, Almacenamiento Local, Almacenamiento Temporal, o Variable. Predeterminado: Ninguno.

Importante

Cuando se utilizan actividades de Variable, solo las operaciones en la misma cadena de operación pueden acceder al valor de la variable durante el tiempo de ejecución.

-

Enviar registros de éxito a: Elija una notificación por correo electrónico para recibir registros exitosos. Seleccione entre las notificaciones por correo electrónico configuradas. Predeterminado: Ninguno.

-

Enviar registros de fallo a: Elija una notificación por correo electrónico para recibir registros fallidos. Seleccione entre las notificaciones por correo electrónico configuradas. Predeterminado: Ninguno.

Nota

Las actividades basadas en archivos y las notificaciones por correo electrónico seleccionadas en estas opciones no necesitan ser parte de una operación desplegada existente. Studio desplegará y gestionará automáticamente estos componentes cuando se seleccionen.

Información detallada sobre el fragmentado

El fragmentado se utiliza para dividir los datos de origen en múltiples fragmentos (lotes) según el tamaño de fragmento configurado. El tamaño del fragmento es el número de registros de origen (nodos) para cada fragmento. La transformación se realiza luego en cada fragmento por separado, con cada fragmento de origen produciendo un fragmento de destino. Los fragmentos de destino resultantes se combinan para producir el destino final.

El fragmentado solo se puede utilizar si los registros son independientes y provienen de una fuente que no es LDAP. Se recomienda utilizar un tamaño de fragmento lo más grande posible, asegurándose de que los datos de un fragmento quepan en la memoria disponible. Para métodos adicionales para limitar la cantidad de memoria que utiliza una transformación, consulte Procesamiento de transformaciones.

Advertencia

El uso del fragmentado afecta el comportamiento de las variables globales y del proyecto. Consulte Uso de variables con fragmentado a continuación.

Limitaciones de la API

Muchas API de servicios web (SOAP/REST) tienen limitaciones de tamaño. Por ejemplo, un upsert basado en Salesforce acepta solo 200 registros por cada llamada. Con suficiente memoria, podría configurar una operación para usar un tamaño de fragmento de 200. La fuente se dividiría en fragmentos de 200 registros cada uno, y cada transformación llamaría al servicio web una vez con un fragmento de 200 registros. Esto se repetiría hasta que todos los registros hayan sido procesados. Los archivos de destino resultantes se combinarían luego. (Tenga en cuenta que también podría utilizar actividades masivas basadas en Salesforce para evitar el uso de fragmentado.)

Procesamiento paralelo

Si tiene una fuente grande y una computadora con múltiples CPU, se puede utilizar el fragmentado para dividir la fuente para el procesamiento paralelo. Dado que cada fragmento se procesa de forma aislada, varios fragmentos pueden procesarse en paralelo. Esto se aplica solo si los registros de origen son independientes entre sí a nivel de nodo de fragmento. Los servicios web se pueden llamar en paralelo utilizando el fragmentado, mejorando el rendimiento.

Al utilizar el fragmentado en una operación donde el destino es una base de datos, tenga en cuenta que los datos de destino se escriben primero en numerosos archivos temporales (uno para cada fragmento). Estos archivos se combinan luego en un solo archivo de destino, que se envía a la base de datos para inserción/actualización. Si establece la variable de Jitterbit jitterbit.target.db.commit_chunks en 1 o true cuando el fragmentado está habilitado, cada fragmento se compromete a la base de datos a medida que se vuelve disponible. Esto puede mejorar significativamente el rendimiento, ya que las inserciones/actualizaciones en la base de datos se realizan en paralelo.

Usar variables con fragmentación

Dado que la fragmentación puede invocar multi-hilo, su uso puede afectar el comportamiento de las variables que no se comparten entre los hilos.

Las variables globales y las variables de proyecto están segregadas entre las instancias de fragmentación, y aunque los datos se combinan, los cambios en estas variables no lo están. Solo se preservan los cambios realizados en el hilo inicial al final de la transformación.

Por ejemplo, si una operación —con fragmentación y múltiples hilos— tiene una transformación que cambia una variable global, el valor de la variable global después de que la operación finaliza es el del primer hilo. Cualquier cambio en la variable en otros hilos es independiente y se descarta cuando la operación se completa.

Estas variables globales se pasan a los otros hilos por valor en lugar de por referencia, asegurando que cualquier cambio en las variables no se refleje en otros hilos u operaciones. Esto es similar a la función RunOperation cuando está en modo asincrónico.