Cómo construir un agente de IA con el Protocolo de Contexto de Modelo (MCP) en Jitterbit Harmony

Introducción

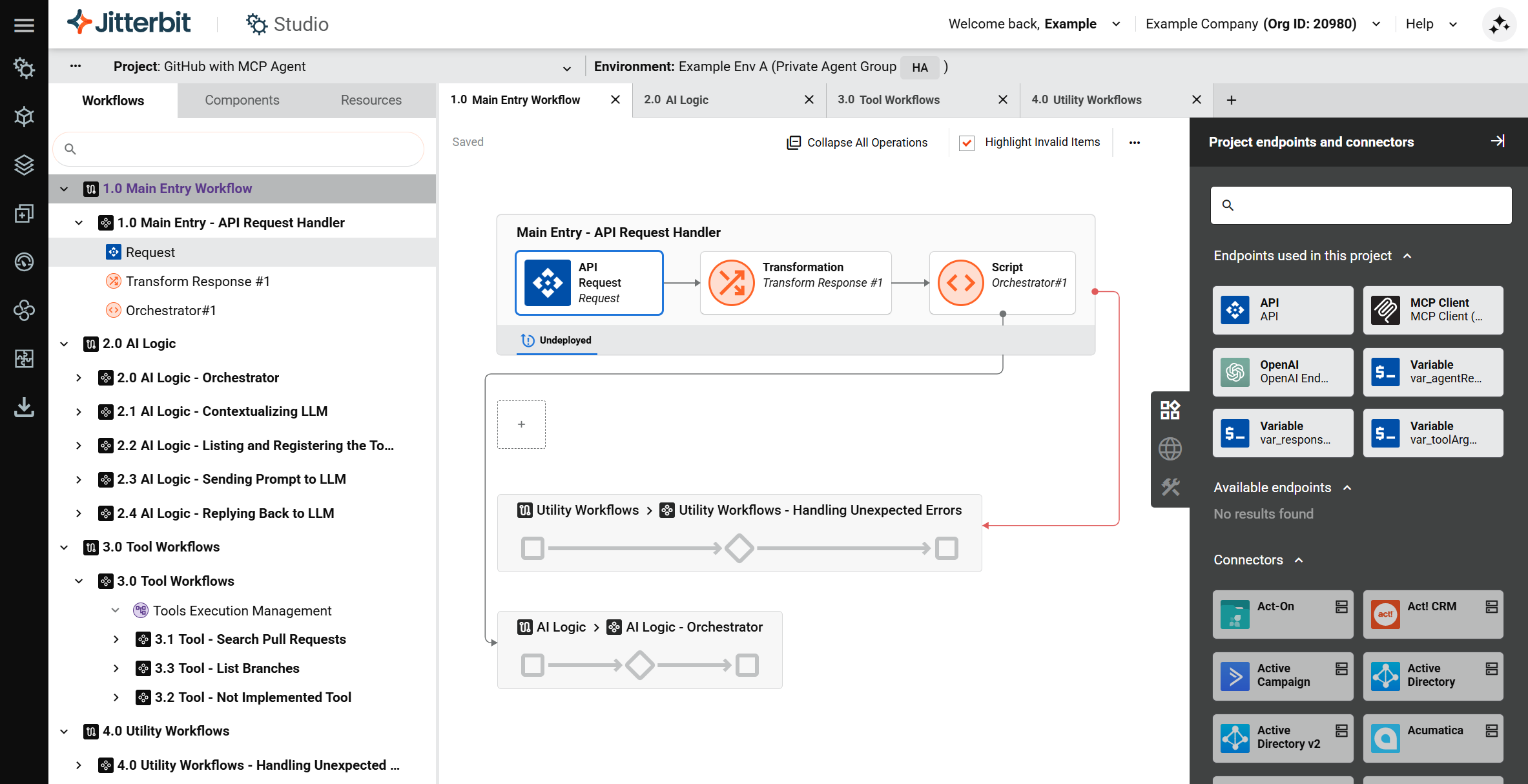

Esta guía muestra cómo construir un agente de IA básico con un cliente MCP en Jitterbit Harmony utilizando Studio. Utiliza el conector de cliente MCP para consumir herramientas proporcionadas por un servidor de Protocolo de Contexto de Modelo (MCP) y actúa como un asistente de chatbot.

El proceso implica establecer el contexto para el modelo de lenguaje grande (LLM), que define al agente como un asistente personal para un ingeniero de software, registrar herramientas para que el LLM sepa qué acciones ejecutar y exponer una API personalizada de Jitterbit para activar el flujo de trabajo que invoca herramientas en el servidor MCP.

Consejo

Para fines de aprendizaje, consulta el Agente de GitHub con MCP proporcionado a través del Jitterbit Marketplace para una implementación de esta guía.

Construir un agente de IA con un cliente MCP

-

Crea un nuevo proyecto en Studio:

- Inicia sesión en el portal de Harmony y selecciona Studio > Proyectos.

- Haz clic en Nuevo Proyecto. Se abre un diálogo de Crear Nuevo Proyecto.

- En el diálogo, ingresa un Nombre del proyecto como

Agente de IA - MCP, selecciona un entorno existente y luego haz clic en Comenzar a Diseñar. Se abre el diseñador de proyectos.

-

Crea el flujo de trabajo de entrada principal y la API personalizada de Jitterbit. Este flujo de trabajo está diseñado para recibir consultas de usuarios a través de la API. Para crear el flujo de trabajo de entrada principal y la API:

-

En el diseñador de proyectos, haz doble clic en el nombre del flujo de trabajo predeterminado y renómbralo a

Entrada Principal - Manejador de Solicitudes de API. -

En la pestaña Puntos finales y conectores del proyecto del panel de componentes de diseño, en la categoría Puntos finales disponibles, haz clic en API para mostrar los tipos de actividad que se pueden crear. Luego, haz clic y arrastra el tipo de actividad Solicitud a la zona de caída en el lienzo de diseño.

-

Haz doble clic en la actividad API Request para configurarla. Define un nuevo esquema JSON de la siguiente manera:

{ "prompt": "<string>" } -

Pasa el cursor a la derecha de la actividad API Request, haz clic en la zona de arrastre y selecciona New Transformation. Se abre una pantalla de configuración.

-

Crea el esquema de destino según sea apropiado y mapea los campos dentro de la transformación de acuerdo con tus datos y caso de uso. Consulta el GitHub Agent with MCP proporcionado a través de Jitterbit Marketplace para ejemplos de transformación de datos.

-

Haz doble clic en el nombre de operación predeterminado y cámbialo por uno apropiado, por ejemplo,

Main Entry - API Request Handler(igual que el nombre del flujo de trabajo). -

Haz clic en el menú de acciones de la operación y selecciona Deploy > Deploy.

-

Crea una API personalizada de Jitterbit para aceptar y analizar las cargas útiles de consultas de usuario:

- Haz clic en el menú de acciones de la operación y selecciona Publish as an API o selecciona Publish as an API using AI.

- Mantén la configuración predeterminada excepto por lo siguiente:

- Method:

POST - Response Type:

System Variable

- Method:

- Retén la URL del servicio de la API publicada.

-

-

Crea el flujo de trabajo principal de lógica de IA. El propósito de este flujo de trabajo es manejar las llamadas LLM y devolver respuestas. Para crear el flujo de trabajo principal de lógica de IA:

-

Haz clic en Add New Workflow en la parte superior del lienzo de diseño para crear un nuevo flujo de trabajo.

-

Haz doble clic en el nombre del flujo de trabajo predeterminado y cámbialo a

Main - AI Logic. -

Usa un connector para crear un punto final que se conecte al servicio LLM que estás utilizando (por ejemplo, Amazon Bedrock, Azure OpenAI, Google Gemini, o OpenAI). En la pestaña Project endpoints and connectors de la paleta de componentes de diseño, bajo la categoría Available endpoints, haz clic en el punto final para mostrar sus tipos de actividad, luego arrastra una actividad a la zona de arrastre en el lienzo de diseño y haz doble clic en ella para configurarla con información como un prompt para enviar al LLM y establecer el contexto.

-

Pasa el cursor a la derecha de la actividad recién creada, haz clic en la zona de caída y selecciona Nueva Transformación. Se abre una pantalla de configuración. Mapea la respuesta del LLM en una salida estructurada. Consulta el Agente de GitHub con MCP para un ejemplo.

-

Usa el conector del Cliente MCP para crear un endpoint que se conecte al servidor MCP que estás utilizando, luego arrastra su tipo de actividad Listar Herramientas a una nueva zona de caída de operación en el lienzo de diseño para crear otra operación.

-

Arrastra un tipo de actividad Registrar Herramientas para tu LLM a la misma operación, a la derecha de la actividad Listar Herramientas, luego coloca una transformación entre ellas. Mapea la salida de la lista de herramientas a la entrada para registrar herramientas con el LLM. Una vez que las herramientas estén registradas con el LLM, tendrá acceso para ejecutar las acciones definidas por esas herramientas.

-

Crea operaciones adicionales para enviar el prompt al LLM y para que el LLM responda, refiriéndote a los ejemplos proporcionados en Agente de GitHub con MCP.

-

-

Conecta los dos flujos de trabajo para que el flujo de trabajo principal de lógica de IA reciba la consulta del usuario del flujo de trabajo de entrada principal:

-

Regresa al flujo de trabajo

Main Entry - API Request Handler. -

Agrega un script para llamar al flujo de trabajo de lógica de IA:

- Pasa el cursor a la derecha de la transformación, haz clic en la zona de caída y selecciona Nuevo Script.

- Configura el script para ejecutar la operación en el flujo de trabajo

Main - AI Agent Tools Logicutilizando la funciónRunOperation. Para un ejemplo, consulta el scriptOrquestador #1en Agente de GitHub con MCP.

-

-

Crea el flujo de trabajo de herramientas. En él, agrega una operación para cada herramienta que desees que el LLM pueda invocar, refiriéndote a los ejemplos proporcionados en Agente de GitHub con MCP. Si tienes muchas herramientas, puedes usar variables para proporcionar los valores de configuración necesarios para configurar los pasos de operación.

-

Crea cualquier flujo de trabajo de utilidad. Un flujo de trabajo sugerido para el manejo de errores se incluye como ejemplo en Agente de GitHub con MCP.

-

Haz clic en el menú de acciones del proyecto y selecciona Desplegar Proyecto.