Plugin de creación de AWS S3 (obsoleto) para grupos de agentes en la nube y privados de Jitterbit

Introducción

El plugin de creación de AWS S3 sube un archivo a Amazon AWS S3 como un objetivo en una operación.

Este plugin está disponible por defecto en grupos de agentes en la nube de Jitterbit y también puede asociarse con grupos de agentes privados.

Esta página detalla los pasos para usar el plugin de creación de AWS S3:

- Descargar y agregar el plugin

- Asociar el plugin con un grupo de agentes

- Asignar el plugin a un objetivo

- Establecer variables globales para el plugin

- Completar la configuración de la operación

Importante

Los plugins proporcionados por Jitterbit están obsoletos.

Cifrado

El plugin de creación de AWS S3 envía tu ID de clave de acceso de AWS S3 y la clave de acceso secreta proporcionados (descritos a continuación en Establecer variables globales para el plugin) a Amazon. La seguridad es manejada por Amazon como se describe en la documentación de Amazon sobre Credenciales de Seguridad de AWS.

Versiones

Estas versiones del plugin de creación de AWS S3 están disponibles:

-

1.0.2.0: Lanzado con Harmony 11.56, esta versión es compatible con todas las versiones de agentes soportadas. De lo contrario, tiene la misma funcionalidad que la versión 1.0.1.0.

-

1.0.1.0: Soporta buckets S3 que utilizan una de estas opciones de cifrado:

- Ninguno: Sin cifrado

- AES-256: Cifrado del lado del servidor con claves gestionadas por Amazon S3 (SSE-S3)

- AWS-KMS: Cifrado del lado del servidor con claves gestionadas por AWS KMS (SSE-KMS)

Esta versión es incompatible con algunas versiones de agentes y devolverá un error en la ejecución.

-

1.0.0.0: Soporta el uso de sin cifrado o AES-256. El cifrado KMS no es compatible con esta versión.

Esta versión es incompatible con algunas versiones de agente y devolverá un error al ejecutarse.

Uso

El plugin AWS S3 Create se puede utilizar siempre que necesite subir archivos a AWS.

En un caso de uso común, este plugin se puede utilizar para mover grandes cantidades de datos a un almacén de datos Snowflake cuando se usa con Snowpipe. Para utilizar esta configuración recomendada, siga la documentación de Snowpipe de Snowflake, luego configure el plugin AWS S3 Create como se describe en esta página.

Nota

Se recomienda utilizar Snowpipe y el plugin AWS S3 Create para aumentar el rendimiento en lugar de usar el controlador JDBC de Snowflake, aunque también es posible instalar el controlador JDBC de Snowflake y luego usar Snowflake como un objetivo de base de datos en Design Studio.

Funcionalidad adicional

Además, estas opciones ofrecen funcionalidad adicional más allá del plugin AWS S3 Create:

-

AWS S3 Get: AWS S3 get es un plugin proporcionado por Jitterbit que se utiliza para leer, renombrar o eliminar un archivo de Amazon AWS S3. Un archivo que se lee puede luego ser utilizado como un origen de datos dentro de una operación (ver Crear una operación en Design Studio).

-

AWS REST API: La API REST de AWS se puede acceder a través de un origen HTTP o objetivo HTTP en Design Studio. Durante la configuración, puede ser necesario utilizar el plugin generador HMAC-SHA256 dependiendo de su método de autenticación. Si necesita asistencia, por favor contacte al soporte.

Descargar y agregar el plugin

El plugin AWS S3 Create es un plugin estándar de Jitterbit que ya está disponible en la página de Plugins de la Consola de Administración y no necesita ser descargado ni agregado a la organización.

Asociar el plugin con un grupo de agentes

El plugin AWS S3 Create se asocia por defecto con los grupos de agentes en la nube de Jitterbit.

Si se utiliza un grupo de agentes privado, antes de poder usar el plugin, debe asociarse con el grupo de agentes privado para que el plugin esté disponible en todos los agentes del grupo.

El plugin se lista en la página de Plugins de la Consola de Administración con un nombre de visualización de Jitterbit AWS S3 Create.

Asignar el plugin a un destino

En un proyecto de Design Studio, debe asignar el plugin a un destino dentro de una operación (ver Crear una operación). Se proporciona una configuración de operación de ejemplo al final de esta página.

Dentro del proyecto:

-

Crear una operación. Cualquier operación que use un destino puede ser utilizada.

-

Crear un destino ficticio al que se asignará el plugin. Este destino se utiliza como un marcador de posición y no se escribirá realmente. Se recomienda usar una fuente de tipo archivo como Almacenamiento Temporal, archivo local, o sitio FTP y proporcionar un valor de Nombre(s) de archivo de

[file].[ext]. Esto asegurará que el archivo tenga el mismo nombre y extensión que el que proviene de la fuente.Nota

También se puede usar un destino de variable global si se está escribiendo un solo archivo en S3.

-

Asigne el complemento al destino. Para hacer esto, haga clic derecho en la fuente y seleccione Complemento. En la ventana emergente, bajo Complementos disponibles, seleccione "Jitterbit AWS S3 Get" y haga clic en Asignar. Luego haga clic en Aceptar.

Consejo

La documentación detallada sobre la asignación de complementos está disponible en Aplicar complementos de pipeline.

Establecer variables globales para el complemento

Para que un complemento asignado a un destino sea funcional, se deben establecer las variables globales requeridas por el complemento. Estas variables se establecen en un script, que debe colocarse antes del destino en la operación para que las variables puedan ser inicializadas. Los scripts a menudo se establecen antes de la fuente en una operación, que también está antes del destino.

Para agregar un script antes de la fuente y el destino en la operación:

-

Haga clic derecho en la fuente en la operación y seleccione Insertar antes de esto > Script.

-

Cree un nuevo Script de Jitterbit que establezca las variables utilizadas por el complemento para autenticar con su bucket de S3 y cargar cualquier archivo que especifique. A continuación se proporciona una plantilla de script para las variables requeridas, seguida de documentación sobre todas las posibles variables que pueden incluirse dentro del script.

Script de creación de AWS S3<trans> $AWS.S3.BUCKET_NAME="<YOUR_BUCKET_NAME>"; $AWS.S3.ACCESS_KEY_ID="<YOUR_ACCESS_KEY>"; $AWS.S3.SECRET_ACCESS_KEY="<YOUR_SECRET_KEY>"; </trans>

| Nombre | Tipo | Requerido | Descripción |

|---|---|---|---|

AWS.S3.ENDPOINT |

Cadena | Opcional | La URL del endpoint de Amazon AWS S3. Por defecto es "s3.amazonaws.com" si no se establece. Los nombres de endpoint válidos por región se proporcionan en la documentación de Amazon Regiones y endpoints de AWS. |

AWS.S3.BUCKET_NAME |

Cadena | Requerido | El nombre del bucket de destino en S3 (por ejemplo, "my_bucket"). |

AWS.S3.ACCESS_KEY_ID |

Cadena | Requerido | La clave de acceso de S3 (por ejemplo, "ABCDEFGHI1JK2LM3NOPQ"). |

AWS.S3.SECRET_ACCESS_KEY |

Cadena | Requerido | La clave de acceso secreta de S3 (por ejemplo, "1aBCd2e/F34gH56IJ7Kl/Mno8pqRsTUvw9x0yzzz"). |

AWS.S3.REGION |

Cadena | Opcional | La región de S3. Por defecto es "DEFAULT_REGION" si no se establece (no recomendado). Los nombres actuales de las regiones se proporcionan en la documentación de Amazon Regiones y endpoints de AWS. |

AWS.S3.OBJECT_KEY |

Cadena | Opcional | La clave del objeto S3 que se va a escribir. Este es el nombre del archivo específico que está subiendo, como "myfile.txt". Para escribir en una carpeta existente dentro del bucket, agregue el nombre de la carpeta después de una barra diagonal (por ejemplo, "my_folder/myfile.txt"). La carpeta debe existir previamente. Si esta variable no se incluye en el script, solo se devolverá un archivo en el bucket y la carpeta (si se especifica). No se admite especificar múltiples archivos o usar comodines. |

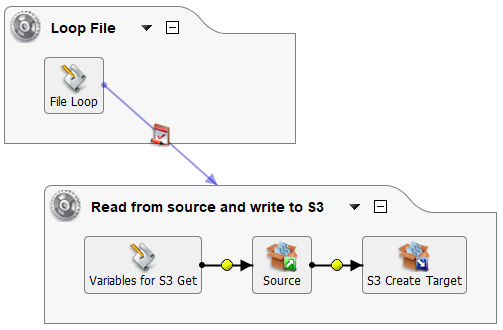

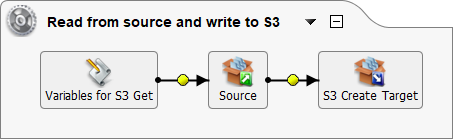

Configuración completa de la operación

La parte del complemento de la configuración de la operación está completa después de que tengas (1) el script que define las variables que se utilizarán con el complemento y (2) el complemento asignado a un objetivo en la operación.

Para completar la configuración de tu operación, define una fuente de la cual provienen los datos, o agrega tanto una fuente como una transformación si deseas transformar tus datos antes de llegar al bucket S3. Si estás escribiendo un solo archivo en S3, la configuración de la operación está completa.

Si deseas escribir múltiples archivos en S3, puedes crear manualmente un script adicional para recorrer los archivos en tu bucket S3. Asegúrate de no haber establecido ningún valor en la variable AWS.S3.OBJECT_KEY.

Dado que solo se devuelve un archivo con el complemento, puedes ejecutar cada archivo por separado a través de la operación. Por ejemplo, utilizando una combinación de FileList, While y RunOperation y una nueva variable global definida SingleFile, este script recoge cada archivo y luego ejecuta la operación con el complemento:

<trans>

Files = FileList("<TAG>Sources/All Files</TAG>");

i = 0;

while(i< length(Files),

$SingleFile = Files[i];

RunOperation("<TAG>Operations/Read from source and write to S3</TAG>");

i++;

)

</trans>

Para usar con el script anterior, querrás hacer referencia a la nueva variable global [SingleFile] en el Obtener Archivos de tu fuente de tipo archivo. Este ejemplo puede ajustarse para su uso con otras configuraciones.