So erstellen Sie einen KI-Agenten mit dem Model Context Protocol (MCP) in Jitterbit Harmony

Einführung

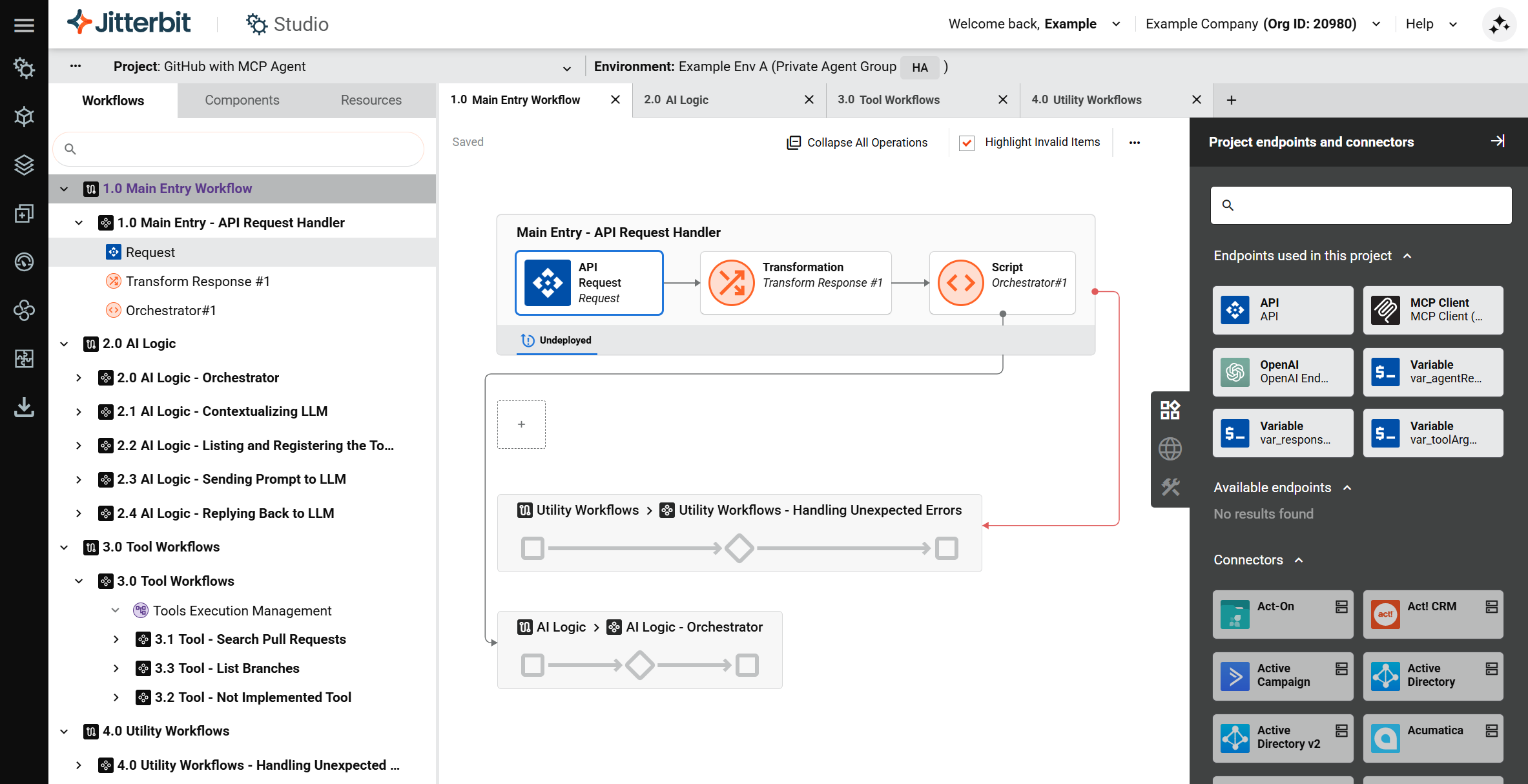

Dieser Leitfaden zeigt, wie man einen grundlegenden KI-Agenten mit einem MCP-Client in Jitterbit Harmony unter Verwendung von Studio erstellt. Er nutzt den MCP-Client-Connector, um Werkzeuge zu konsumieren, die von einem Model Context Protocol (MCP)-Server bereitgestellt werden, und fungiert als Chatbot-Assistent.

Der Prozess umfasst das Festlegen des Kontexts für das große Sprachmodell (LLM), das den Agenten als persönlichen Assistenten für einen Softwareingenieur definiert, das Registrieren von Werkzeugen, damit das LLM weiß, welche Aktionen ausgeführt werden sollen, und das Bereitstellen einer benutzerdefinierten Jitterbit-API, um den Workflow auszulösen, der Werkzeuge auf dem MCP-Server aufruft.

Tipp

Zu Lernzwecken verweisen Sie auf den GitHub-Agenten mit MCP, der über den Jitterbit Marketplace bereitgestellt wird, für eine Implementierung dieses Leitfadens.

Erstellen Sie einen KI-Agenten mit einem MCP-Client

-

Erstellen Sie ein neues Studio-Projekt:

- Melden Sie sich im Harmony-Portal an und wählen Sie Studio > Projekte.

- Klicken Sie auf Neues Projekt. Ein Dialogfeld Neues Projekt erstellen öffnet sich.

- Geben Sie im Dialogfeld einen Projektnamen wie

KI-Agent - MCPein, wählen Sie eine vorhandene Umgebung aus und klicken Sie dann auf Design starten. Der Projekt-Designer öffnet sich.

-

Erstellen Sie den Haupt-Workflow und die benutzerdefinierte Jitterbit-API. Dieser Workflow ist so konzipiert, dass er Benutzeranfragen über die API empfängt. Um den Haupt-Workflow und die API zu erstellen:

-

Doppelklicken Sie im Projekt-Designer auf den Standard-Workflow-Namen und benennen Sie ihn in

Haupt-Workflow - API-Anforderungsbearbeiterum. -

Klicken Sie im -Tab Projektendpunkte und -connectoren der Design-Komponentenpalette unter der Kategorie Verfügbare Endpunkte auf API, um die Aktivitätstypen anzuzeigen, die erstellt werden können. Ziehen Sie dann den -Aktivitätstyp Anforderung in die Ablagezone auf der Design-Leinwand.

-

Doppelklicken Sie auf die API-Anfrage-Aktivität, um sie zu konfigurieren. Definieren Sie ein neues JSON-Schema wie folgt:

{ "prompt": "<string>" } -

Bewegen Sie den Mauszeiger rechts neben der API-Anfrage-Aktivität, klicken Sie auf die Drop-Zone und wählen Sie Neue Transformation. Ein Konfigurationsbildschirm öffnet sich.

-

Erstellen Sie das Zielschema entsprechend und mappen Sie die Felder innerhalb der Transformation gemäß Ihren Daten und Anwendungsfällen. Verweisen Sie auf den GitHub-Agent mit MCP, der über den Jitterbit Marketplace bereitgestellt wird, um Beispiele für die Transformation der Daten zu erhalten.

-

Doppelklicken Sie auf den Standardnamen der Operation und benennen Sie ihn entsprechend um, zum Beispiel in

Haupteintrag - API-Anforderungsbearbeiter(gleich wie der Workflow-Name). -

Klicken Sie auf das Aktionsmenü der Operation und wählen Sie Bereitstellen > Bereitstellen.

-

Erstellen Sie eine benutzerdefinierte Jitterbit-API, um Benutzerabfrage-Payloads zu akzeptieren und zu parsen:

- Klicken Sie auf das Aktionsmenü der Operation und wählen Sie Als API veröffentlichen oder wählen Sie Als API unter Verwendung von KI veröffentlichen.

- Behalten Sie die Standardeinstellungen bei, mit Ausnahme der folgenden:

- Methode:

POST - Antworttyp:

Systemvariable

- Methode:

- Behalten Sie die Dienst-URL der veröffentlichten API bei.

-

-

Erstellen Sie den Haupt-Workflow für die KI-Logik. Der Zweck dieses Workflows besteht darin, LLM-Aufrufe zu verarbeiten und Antworten zurückzugeben. Um den Haupt-Workflow für die KI-Logik zu erstellen:

-

Klicken Sie auf Neuen Workflow hinzufügen oben auf der Design-Leinwand, um einen neuen Workflow zu erstellen.

-

Doppelklicken Sie auf den Standardnamen des Workflows und benennen Sie ihn in

Haupt - KI-Logikum. -

Verwenden Sie einen Connector, um einen Endpunkt zu erstellen, der mit dem LLM-Dienst verbunden ist, den Sie verwenden (zum Beispiel Amazon Bedrock, Azure OpenAI, Google Gemini, oder OpenAI). Klicken Sie im -Tab Projektendpunkte und -connectoren der Design-Komponentenpalette unter der Kategorie Verfügbare Endpunkte auf den Endpunkt, um seine Aktivitätstypen anzuzeigen, ziehen Sie dann eine Aktivität in die Drop-Zone auf der Design-Leinwand und doppelklicken Sie darauf, um sie mit Informationen wie einem Prompt zu konfigurieren, der an das LLM gesendet wird, um den Kontext festzulegen.

-

Bewege den Mauszeiger rechts neben der neu erstellten Aktivität, klicke auf die Drop-Zone und wähle Neue Transformation. Ein Konfigurationsbildschirm öffnet sich. Ordne die LLM-Antwort einem strukturierten Output zu. Siehe das Beispiel im GitHub-Agent mit MCP.

-

Verwende den MCP-Client-Connector, um einen Endpunkt zu erstellen, der mit dem MCP-Server verbunden ist, den du verwendest, und ziehe dann den Aktivitätstyp List Tools in eine neue Operation-Drop-Zone auf der Design-Leinwand, um eine weitere Operation zu erstellen.

-

Ziehe einen Aktivitätstyp Register Tools für dein LLM in dieselbe Operation, rechts von der Aktivität List Tools, und platziere dann eine Transformation zwischen ihnen. Ordne die Ausgabe aus der Werkzeugliste der Eingabe zum Registrieren von Werkzeugen beim LLM zu. Sobald die Werkzeuge beim LLM registriert sind, hat es Zugriff auf die Aktionen, die durch diese Werkzeuge definiert sind.

-

Erstelle zusätzliche Operationen, um die Eingabeaufforderung an das LLM zu senden und damit das LLM zu antworten, und verweise auf die in GitHub-Agent mit MCP bereitgestellten Beispiele.

-

-

Verbinde die beiden Workflows, damit der Haupt-AI-Logik-Workflow die Benutzeranfrage vom Haupt-Eingangs-Workflow erhält:

-

Kehre zum Workflow

Main Entry - API Request Handlerzurück. -

Füge ein Skript hinzu, um den AI-Logik-Workflow aufzurufen:

- Bewege den Mauszeiger rechts neben der Transformation, klicke auf die Drop-Zone und wähle Neues Skript.

- Konfiguriere das Skript so, dass es die Operation im Workflow

Main - AI Agent Tools Logicmit der FunktionRunOperationausführt. Siehe das Beispiel im SkriptOrchestrator #1in GitHub-Agent mit MCP.

-

-

Erstelle den Workflow für die Werkzeuge. Füge darin eine Operation für jedes Werkzeug hinzu, das das LLM aufrufen können soll, und verweise auf die in GitHub-Agent mit MCP bereitgestellten Beispiele. Wenn du viele Werkzeuge hast, kannst du Variablen verwenden, um die Konfigurationswerte bereitzustellen, die für die Konfiguration der Operationsschritte erforderlich sind.

-

Erstellen Sie beliebige Dienstprogrammarbeitsabläufe. Ein vorgeschlagener Arbeitsablauf für die Fehlerbehandlung ist als Beispiel im GitHub-Agent mit MCP enthalten.

-

Klicken Sie im Aktionsmenü des Projekts auf Projekt bereitstellen.